Wenn du Google nutzt, hinterlässt du wertvolle Daten durch Suchanfragen und Klicks. Diese Nutzerreaktionen helfen Google, die Qualität der Suchergebnisse und Werbung zu verbessern. Die Auswertung erfolgt mit Verzögerung – aus technischen und datenschutzrechtlichen Gründen. So sorgt Google für genauere Analysen und besseren Schutz deiner Daten, während du das Internet genießt.

Einleitung und Bedeutung der Nutzerreaktionen

Im digitalen Zeitalter spielt die Interaktion der Nutzer mit Online-Diensten eine zentrale Rolle. Wenn du Google verwendest, hinterlässt du durch Suchanfragen, Klicks und andere Aktivitäten wertvolle Daten. Diese sogenannten Nutzerreaktionen sind für Google essenziell, um seine Dienste kontinuierlich zu verbessern und personalisierte Ergebnisse zu liefern.

Die Bedeutung dieser Nutzerreaktionen liegt darin, dass sie als Feedbackmechanismus fungieren. Durch die Analyse dieser Daten kann Google erkennen, welche Inhalte relevant sind, wie Nutzer mit der Suchmaschine interagieren und wo Optimierungsbedarf besteht. Dies betrifft sowohl die Qualität der Suchergebnisse als auch die Ausspielung von Werbung.

Allerdings erfolgt die Auswertung dieser Nutzerreaktionen nicht unmittelbar. Stattdessen wertet Google die gesammelten Daten mit einer gewissen Verzögerung aus. Diese Verzögerung ist bewusst und hat vielfältige Gründe, die sowohl technischer als auch rechtlicher Natur sind. Sie dient dazu, die Genauigkeit der Analysen zu erhöhen und sicherzustellen, dass die Datenverarbeitung den Datenschutzanforderungen entspricht.

Wesentliche Aspekte der Nutzerreaktionen

- Suchanfragen und Klickverhalten

- Verweildauer auf Webseiten

- Interaktionen mit Werbeanzeigen

- Nutzung von Google-Diensten auf verschiedenen Endgeräten

Diese Informationen bilden die Grundlage für das Verständnis, warum eine verzögerte Auswertung nicht nur notwendig, sondern auch vorteilhaft für die Qualität der angebotenen Services ist.

Grundlagen der Datenverarbeitung bei Google

Google verarbeitet enorme Mengen an Daten, die durch Nutzerinteraktionen auf verschiedensten Plattformen wie der Websuche, YouTube, Google Maps oder Google Ads generiert werden. Die Grundlage dieser Datenverarbeitung bildet eine komplexe Infrastruktur, die in der Lage ist, Informationen aus unterschiedlichen Quellen effizient zu sammeln, zu speichern und zu analysieren.

Diese Verarbeitung erfolgt nicht in Echtzeit, sondern meist in mehreren Schritten und mit zeitlicher Verzögerung. Dabei sind verschiedene Technologien und Systeme im Einsatz, darunter verteilte Datenbanken, Data Warehouses und spezialisierte Analyse-Tools. Google nutzt Data-Center weltweit, um die Datenverarbeitung so skalierbar und robust wie möglich zu gestalten.

Grundsätzlich läuft die Datenverarbeitung bei Google in folgenden Phasen ab:

- Datenerfassung: Nutzerreaktionen werden über verschiedene Dienste hinweg erfasst, beispielsweise durch Klicks, Verweildauer oder Bewertungen.

- Datenvorverarbeitung: Rohdaten werden bereinigt, normalisiert und mit Metadaten angereichert, um eine einheitliche Basis für die Analyse zu schaffen.

- Datenintegration: Unterschiedliche Datenquellen werden zusammengeführt, um einen umfassenden Überblick über Nutzerverhalten und -interaktionen zu erhalten.

- Datenanalyse: Die Informationen werden ausgewertet, Algorithmen zur Mustererkennung und Trendprognosen werden angewandt.

- Ergebniserstellung: Die gewonnenen Erkenntnisse fließen in Produktverbesserungen und personalisierte Nutzererfahrungen ein.

Diese mehrstufigen Prozesse erfordern Zeit, da ein reibungsloser Ablauf, hohe Datenqualität und Genauigkeit oberste Priorität haben. Zudem werden Sicherheit und Datenschutz konsequent berücksichtigt, was technischen Mehraufwand bedeutet.

Google verwendet verschiedene Technologien wie Bigtable, MapReduce und TensorFlow, um die riesigen Datenmengen effizient zu verarbeiten. Hierbei handelt es sich um bewährte Systeme zur skalierbaren Datenhaltung, parallelen Verarbeitung und maschinellem Lernen, die eng zusammenarbeiten, aber auch zeitliche Puffer für Datenvalidierung und -aggregation benötigen.

Zusammengefasst basieren die Grundlagen der Datenverarbeitung bei Google auf einer ausgeklügelten Kombination von Hardware, Software und Algorithmen, die große Datenvolumen in mehreren Stufen analysieren. Diese Struktur sorgt für zuverlässige Ergebnisse, allerdings mit einer unvermeidlichen Verzögerung bei der Auswertung von Nutzerreaktionen.

Technische Gründe für Verzögerungen bei der Auswertung

Die Auswertung von Nutzerreaktionen bei Google ist aus technischen Gründen häufig mit Verzögerungen verbunden. Diese resultieren vor allem aus der Komplexität der Datenverarbeitung und dem Umfang der täglich erfassten Informationen. Google sammelt eine enorme Menge an Interaktionsdaten – von Suchanfragen über Klicks bis hin zu Verweildauer und weiteren Signalen. Um diese Daten korrekt und zuverlässig auszuwerten, sind umfangreiche Rechenressourcen und komplexe Verarbeitungsschritte notwendig.

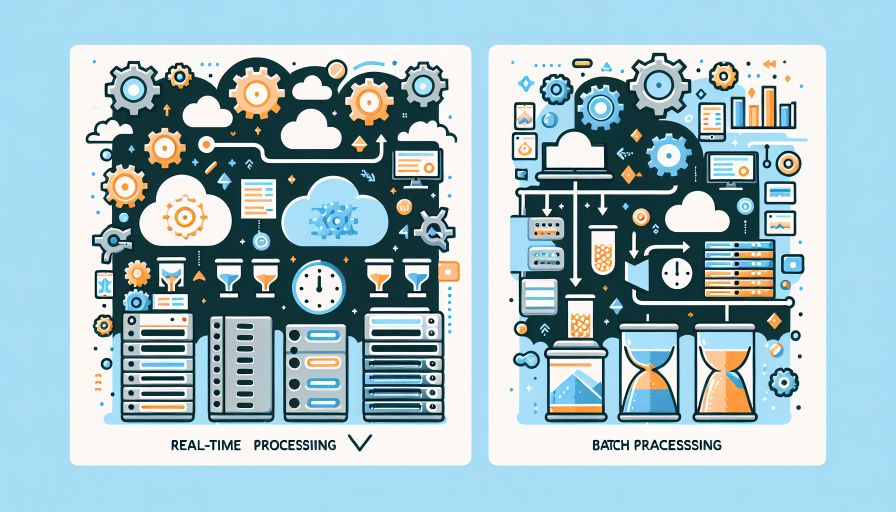

Ein Hauptgrund für die Verzögerungen liegt in der Art und Weise, wie Google seine Daten verarbeitet. Die meisten Analysen erfolgen nicht in Echtzeit, sondern in Batch-Verfahren. Dabei werden Daten in größeren Mengen gesammelt und dann in regelmäßigen Abständen zusammengeführt und analysiert. Diese Methode ist effizienter im Umgang mit großen Datenmengen und ermöglicht umfassendere Auswertungen, führt jedoch zwangsläufig zu Verzögerungen.

Darüber hinaus muss die Datenverarbeitung mehrere Schritte durchlaufen:

- Datenerfassung und Speicherung

- Datenbereinigung und Qualitätskontrolle

- Aggregation und Normalisierung der Daten

- Analyse durch Algorithmen und statistische Modelle

- Integration der Ergebnisse in Such- und Werbe-Algorithmen

Jeder dieser Schritte erfordert Zeit und Rechenkapazität. Besonders die Phase der Datenbereinigung ist entscheidend, um Inkonsistenzen oder Fehler in den Rohdaten zu erkennen und zu korrigieren. Ohne diesen Prozess wäre die Genauigkeit der Auswertung gefährdet.

Zudem betreibt Google seine Datenzentren weltweit verteilt, was zusätzliche Latenzzeiten verursacht, da Daten zwischen verschiedenen Standorten synchronisiert und verarbeitet werden müssen. Dieses verteilte System sorgt zwar für Ausfallsicherheit und Skalierbarkeit, bringt aber weitere technische Komplexitäten mit sich, die eine sofortige Auswertung erschweren.

Datenschutz und rechtliche Vorgaben als Einflussfaktor

Datenschutz und rechtliche Vorgaben spielen eine zentrale Rolle bei der Verzögerung der Auswertung von Nutzerreaktionen durch Google. In der Europäischen Union beispielsweise muss Google die Anforderungen der Datenschutz-Grundverordnung (DSGVO) erfüllen. Diese schreibt vor, dass personenbezogene Daten nur unter bestimmten Bedingungen erhoben und verarbeitet werden dürfen. Das hat direkten Einfluss auf die Geschwindigkeit, mit der Nutzerreaktionen ausgewertet werden können.

Google ist verpflichtet, vor der Verarbeitung sicherzustellen, dass die Daten anonymisiert oder zumindest pseudonymisiert sind, um die Privatsphäre der Nutzer zu schützen. Dieser Prozess benötigt Zeit und führt zwangsläufig zu Verzögerungen bei der Auswertung. Darüber hinaus müssen Nutzerrechte beachtet werden, wie das Recht auf Auskunft, Berichtigung oder Löschung der eigenen Daten, was einen zusätzlichen Verwaltungsaufwand bedeutet.

Auch nationale Datenschutzgesetze außerhalb Europas stellen eigene Anforderungen, die Google einhalten muss. Die Einhaltung dieser vielfältigen und oft komplexen Vorgaben erfordert zusätzliche Prüfungen und Kontrollmechanismen, bevor die Daten verwendet werden dürfen.

Folgende rechtliche und datenschutzbezogene Faktoren beeinflussen die Auswertung von Nutzerreaktionen:

- Datenminimierung: Es dürfen nur die nötigsten Daten erhoben werden.

- Transparenzpflicht: Nutzer müssen darüber informiert sein, wie ihre Daten genutzt werden.

- Zustimmungsanforderungen: In vielen Fällen ist eine aktive Einwilligung der Nutzer nötig.

- Sicherheitsmaßnahmen: Daten müssen vor unberechtigtem Zugriff geschützt werden.

- Speicherbegrenzung: Daten dürfen nur so lange gespeichert werden, wie es für den Zweck notwendig ist.

Diese Vorgaben erfordern komplexe technische und organisatorische Maßnahmen, die eine unmittelbare Echtzeitanalyse erschweren. So wird sichergestellt, dass die Verarbeitung der Nutzerreaktionen sowohl rechtlich sicher als auch respektvoll gegenüber den Rechten der Nutzer erfolgt.

Komplexität der Analyseverfahren bei Nutzerinteraktionen

Die Auswertung von Nutzerinteraktionen bei Google ist ein höchst komplexer Prozess, der mehrere Ebenen der Analyse umfasst. Nutzerreaktionen, wie Klicks, Suchanfragen oder Verweildauer, werden nicht einfach nur gesammelt, sondern müssen im Kontext unterschiedlichster Faktoren interpretiert werden. Diese Komplexität führt dazu, dass die Verarbeitung meist verzögert erfolgt.

Ein wesentlicher Aspekt ist die Aggregation und Normalisierung der Daten. Google erhält täglich Milliarden von Nutzerinteraktionen, die in ihrer Rohform sehr heterogen sind. Um aussagekräftige Erkenntnisse zu gewinnen, müssen diese Daten bereinigt, klassifiziert und in ein einheitliches Format gebracht werden. Dazu zählen unter anderem:

- Das Herausfiltern von Spam und ungültigen Interaktionen

- Die Berücksichtigung von Mehrdeutigkeiten in Suchanfragen

- Die Korrektur technischer Fehler bei der Datenerfassung

Darüber hinaus sind kontextuelle Analysen notwendig, um die Absicht hinter einer Nutzeraktion zu verstehen. Beispielsweise können Klicks auf Suchergebnisse sehr unterschiedlich zu bewerten sein, je nachdem, ob sie aus Mobil- oder Desktop-Geräten stammen, von wiederkehrenden oder neuen Nutzern ausgehen oder in welchem zeitlichen Abstand sie stattfinden.

Zur weiteren Komplexität trägt die multivariate Datenanalyse bei, bei der zahlreiche Variablen und Metadaten miteinander verknüpft werden, um Muster und Trends zu erkennen. Solche statistischen Modelle und Algorithmen benötigen Rechenzeit und Ressourcen und können nicht in Echtzeit ausgeführt werden.

Hinzu kommt die kontinuierliche Anpassung der Bewertungsmodelle. Google optimiert seine Algorithmen ständig, was bedeutet, dass historische Daten auch rückwirkend neu bewertet werden, um langfristige Trends zu identifizieren und Fehlinterpretationen zu vermeiden.

Auswirkungen auf Suchergebnisse und Werbung

Die verzögerte Auswertung von Nutzerreaktionen durch Google hat direkte Auswirkungen auf die Suchergebnisse und die Werbung. Da Google Zeit benötigt, um verschiedene Signale wie die Klickrate (CTR), Verweildauer und weitere Interaktionen zuverlässig zu erfassen und auszuwerten, spiegeln die Rankings der Suchergebnisse nicht immer den aktuellen Stand der Nutzerpräferenzen wider. Diese Verzögerung sorgt einerseits für eine stabilere und qualitativ hochwertigere Einordnung von Webseiten, andererseits können aktuelle Trends oder Veränderungen erst verzögert im Ranking sichtbar werden.

Für Webseitenbetreiber und Vermarkter bedeutet dies:

- Die Optimierung von Nutzersignalen zahlt sich nicht sofort aus, sondern zeigt ihre Wirkung häufig erst nach einer gewissen Zeitspanne.

- Eine nachhaltige und strategische Verbesserung der Nutzererfahrung ist wichtiger als kurzfristige Manipulationsversuche.

- Verlässliche und gesammelte Nutzerdaten führen langfristig zu besseren Rankings und somit zu mehr Sichtbarkeit.

Tools wie Rankmagic können hier gezielt unterstützen. Rankmagic ermöglicht es, echte Nutzersignale durch authentische Suchanfragen und Interaktionen innerhalb des eigenen Netzwerks zu generieren. Diese Nutzersignale beeinflussen wichtige SEO-Kennzahlen, die Google für die Rankingbewertung heranzieht.

Auswirkungen der verzögerten Auswertung auf Suchergebnisse und Werbung im Überblick

| Aspekt | Auswirkung der verzögerten Auswertung |

|---|---|

| Suchergebnisse | Stabileres Ranking durch aggregierte und verifizierte Nutzersignale; aktuelle Änderungen werden verzögert reflektiert |

| Werbung (z.B. Google Ads) | Verzögerung bei der Anpassung von Anzeigenplatzierungen und Geboten basierend auf Nutzerverhalten; ermöglicht jedoch genaueres Targeting |

| SEO-Strategien | Langfristige und nachhaltige Maßnahmen sind effektiver; kurzfristige SEO-Taktiken zeigen verzögerte Wirkung |

| Nutzererfahrung | Verbesserte Relevanz der Suchergebnisse durch fundierte Datenanalyse; verhindert Manipulationen durch gefälschte oder kurzfristige Signale |

Die Verzögerung in der Auswertung sorgt somit für eine vertrauenswürdige, auf echten Nutzerreaktionen basierende Bewertung von Webseiten und Anzeigen. Indem du Nutzersignale mit Hilfe von Systemen wie Rankmagic verbesserst, kannst du die positiven Effekte auf dein Suchmaschinenranking langfristig fördern, auch wenn sich diese Wirkung nicht sofort einstellt.

Rolle von maschinellem Lernen und KI in der Auswertung

Die Rolle von maschinellem Lernen und Künstlicher Intelligenz (KI) ist zentral für die Auswertung von Nutzerreaktionen bei Google. Durch diese Technologien können große Mengen an Daten effizient verarbeitet und analysiert werden – allerdings benötigt dies Zeit, was die Verzögerungen teilweise erklärt.

Maschinelles Lernen erlaubt es Google, Muster in Nutzerreaktionen zu erkennen und relevante Informationen automatisch zu verarbeiten. Dabei kommen verschiedene Algorithmen zum Einsatz, die sich ständig weiterentwickeln und an neue Daten anpassen. KI-Systeme helfen zudem dabei, irrelevante oder fehlerhafte Daten herauszufiltern, um die Qualität der Auswertung zu verbessern.

Ein wesentlicher Aspekt ist, dass maschinelles Lernen oft auf Trainingsdaten angewiesen ist, die gesammelt, bereinigt und vorverarbeitet werden müssen. Dies geschieht meist nicht in Echtzeit, sondern in sogenannten Stapelverarbeitungen, was zu Verzögerungen in der Auswertung führt. Darüber hinaus werden Modelle regelmäßig neu trainiert und optimiert, was zusätzliche Zeit beansprucht.

Beispiele für den Einsatz von KI und maschinellem Lernen bei Google

- Analyse von Klickverhalten und Suchanfragen

- Erkennung von Spam und Manipulationsversuchen

- Personalisierung von Suchergebnissen und Werbung

- Verbesserung der Spracherkennung und Übersetzungsdienste

Diese vielfältigen Anwendungen zeigen, wie komplex und datenintensiv die Auswertung der Nutzerreaktionen ist. Ohne Verzögerungen könnten viele dieser Prozesse nicht in der gewünschten Qualität ablaufen.

Übersicht: Einfluss von maschinellem Lernen auf die Auswertezeit

| Faktor | Auswirkung auf Auswertezeit |

|---|---|

| Datensammlung und Vorverarbeitung | Erfordert Zeit für Bereinigung und Formatierung der Rohdaten |

| Modelltraining und Anpassung | Erfordert wiederholte Verarbeitung großer Datenmengen |

| Qualitätssicherung | Verzögert Echtzeitauswertung durch umfangreiche Prüfprozesse |

| Skalierung der Infrastruktur | Notwendig für Verarbeitung hoher Datenvolumen, aber begrenzt durch Hardware-Ressourcen |

Zusammenfassend lässt sich sagen, dass maschinelles Lernen und KI die Geschwindigkeit der Auswertung zwar erhöhen können, gleichzeitig aber bestimmte Prozessschritte erfordern, die nicht sofort, sondern mit einer gewissen Verzögerung durchgeführt werden. Diese Verzögerung ist ein Ergebnis der notwendigen Balance zwischen Datenqualität, Sicherheit und Performance.

Herausforderungen durch Echtzeit- vs. Stapelverarbeitung

Bei der Auswertung von Nutzerreaktionen steht Google vor der grundlegenden Entscheidung zwischen Echtzeit- und Stapelverarbeitung. Beide Methoden haben eigene Vor- und Nachteile, die sich stark auf die Qualität und Effizienz der Datenanalyse auswirken.

Echtzeitverarbeitung bedeutet, dass die Daten unmittelbar nach ihrer Erfassung analysiert werden. Das ermöglicht schnelle Reaktionen, zum Beispiel bei der Anpassung von Suchergebnissen oder Werbeanzeigen. Allerdings erfordern Echtzeitsysteme hohe technische Ressourcen und bergen das Risiko, dass noch nicht vollständig validierte oder unvollständige Daten verarbeitet werden. Zudem können komplexe Analysen in Echtzeit nicht immer präzise durchgeführt werden, was die Qualität der Ergebnisse beeinträchtigen könnte.

Im Gegensatz dazu steht die Stapelverarbeitung (Batch Processing). Hier werden gesammelte Daten in größeren Mengen gesammelt und zeitlich versetzt analysiert. Diese Methode ermöglicht eine gründlichere Datenprüfung, Qualitätskontrollen und die Anwendung aufwändiger Analysealgorithmen, die in Echtzeit nicht praktikabel wären. Allerdings führt diese Verzögerung dazu, dass Google erst nach einer gewissen Zeit detaillierte Erkenntnisse aus den Nutzerreaktionen gewinnt.

Die Herausforderung besteht darin, ein ausgewogenes Verhältnis zwischen beiden Verarbeitungsarten zu finden. Google nutzt oft eine Kombination aus beiden Ansätzen: kritische beziehungsweise zeitnahe Daten werden relativ schnell verarbeitet, während umfassendere Analysen im Batch-Modus folgen. So lassen sich die Vorteile beider Methoden nutzen, ohne die Nachteile übermäßig zu spüren.

Weitere Faktoren, die diese Herausforderung beeinflussen, sind:

- Skalierbarkeit: Die enormen Datenmengen, die Google täglich verarbeitet, erfordern effiziente Systeme, die bei Echtzeitverarbeitung schnell an Grenzen stoßen.

- Systemstabilität: Batch-Verarbeitung belastet die Systeme zu definierten Zeiten und kann dadurch die Gesamtleistung stabiler halten.

- Fehlerkorrektur: Im Stapelmodus gibt es mehr Zeit, um Fehler oder Ausreißer zu identifizieren und zu korrigieren.

Insgesamt ist die Balance zwischen Echtzeit- und Stapelverarbeitung eine technische und organisatorische Herausforderung, der Google durch den Einsatz spezialisierter Technologien und kontinuierliche Optimierung begegnet. Dadurch kann sichergestellt werden, dass Nutzerreaktionen zwar nicht immer unmittelbar, aber dennoch zuverlässig und qualitativ hochwertig ausgewertet werden.

Maßnahmen zur Qualitätssicherung der Datenanalyse

Um die Qualität der Datenanalyse sicherzustellen, setzt Google auf verschiedene Maßnahmen, die Verzögerungen bei der Auswertung von Nutzerreaktionen rechtfertigen. Diese Maßnahmen helfen, die Verlässlichkeit und Genauigkeit der Ergebnisse zu erhöhen, was für die Verbesserung von Suchergebnissen und Werbeanzeigen essenziell ist.

Ein zentraler Punkt ist die Datenbereinigung. Google überprüft die eingehenden Daten gründlich, um fehlerhafte, unvollständige oder manipulierte Informationen zu erkennen und auszuschließen. Diese Prüfung benötigt Zeit, da große Datenmengen auf Anomalien oder Inkonsistenzen untersucht werden müssen.

Außerdem spielt die Validierung der Daten eine wichtige Rolle. Hierbei werden Nutzerreaktionen auf ihre Echtheit und Relevanz hin überprüft. Beispielsweise werden Klicks, die von Bots oder automatisierten Skripten stammen könnten, herausgefiltert, damit die Analyse nur auf echten Nutzerdaten basiert.

Ein weiterer wichtiger Aspekt ist die Aggregierung der Daten. Zur Wahrung der Datenschutzbestimmungen und zur Minimierung von Fehlinterpretationen werden einzelne Interaktionen zusammengefasst und anonymisiert. Dieses Zusammenführen von Daten aus verschiedenen Quellen erfolgt nicht in Echtzeit, sondern über definierte Zeiträume, was zu Verzögerungen führt.

Zusätzlich werden komplexe Statistische Modellierungen und Algorithmen angewandt, um aus den gesammelten Daten Muster zu erkennen und zuverlässige Erkenntnisse zu gewinnen. Die Durchführung solcher Berechnungen erfordert Rechenkapazität und Zeit, insbesondere wenn sie kontinuierlich aktualisiert werden sollen.

Nicht zuletzt gehört zum Qualitätssicherungsprozess die manuelle Überwachung und Anpassung bestimmter Analyseprozesse. Zwar setzt Google stark auf automatisierte Systeme, jedoch ist auch das Eingreifen von Data Scientists und Entwicklern notwendig, um die Algorithmen zu überprüfen und zu optimieren.

Zusammengefasst beinhaltet die Qualitätssicherung bei Google folgende Maßnahmen:

- Datenbereinigung zur Entfernung fehlerhafter Informationen

- Validierung der Daten auf Echtheit und Relevanz

- Datenschutzgerechte Aggregierung und Anonymisierung

- Einsatz komplexer statistischer Modelle und Algorithmen

- Manuelle Kontrolle und Anpassung der Analyseverfahren

Diese Maßnahmen tragen entscheidend dazu bei, dass die Nutzerreaktionen nicht nur schnell, sondern vor allem präzise ausgewertet werden – auch wenn dies zwangsläufig mit einer zeitlichen Verzögerung verbunden ist.

Entwicklung und Veränderungen der Verzögerungsstrategie über die Jahre

Über die Jahre hat sich die Strategie von Google zur Verzögerung der Nutzerreaktionsauswertung kontinuierlich weiterentwickelt. Schon in den frühen Tagen der Suchmaschine waren die Systeme und Algorithmen weniger komplex, wodurch die Datenverarbeitung im Vergleich zu heute wesentlich schneller und direkter erfolgte. Mit der zunehmenden Menge an Nutzerdaten und der steigenden Komplexität der Analyseverfahren wurde jedoch eine Anpassung der Verzögerungsstrategie notwendig.

Insbesondere der Ausbau von maschinellem Lernen und künstlicher Intelligenz führte dazu, dass Google umfangreichere und differenziertere Datenanalysen durchführte. Diese Systeme benötigen mehr Rechenkapazität und Zeit, um Muster in den Nutzerreaktionen zu erkennen und zu bewerten. Deshalb wurde die Verzögerung bewusst verlängert, um qualitativ hochwertigere und verlässlichere Daten zu erhalten.

Weiterhin haben sich Datenschutzrichtlinien und rechtliche Anforderungen in den letzten Jahren deutlich verändert und verschärft. Google passt seine Auswertungsprozesse kontinuierlich an diese Vorgaben an, was oft zu zusätzlichen Verzögerungen führt, um sicherzustellen, dass die Datenverarbeitung compliant bleibt und Nutzerrechte gewahrt werden.

Auch organisatorisch hat sich die Verzögerungsstrategie verändert. Durch die Integration neuer Technologien sowie den Ausbau der Infrastruktur können heute verschiedene Datenquellen gleichzeitig verarbeitet und ausgewertet werden, jedoch bleibt die zeitliche Staffelung erhalten, um eine systematische Qualitätssicherung zu gewährleisten und etwaige Fehler frühzeitig zu identifizieren.

Wichtige Entwicklungen im Überblick:

- Zunehmende Komplexität der Algorithmen und Modelle

- Erweiterte Datenschutzanforderungen (z. B. DSGVO)

- Verbesserte Qualitätssicherungsprozesse

- Integration von Echtzeit- und Stapelverarbeitungstechniken

- Skalierung der Infrastruktur für große Datenmengen

Insgesamt spiegelt die Entwicklung der Verzögerungsstrategie bei Google eine Balance zwischen technologischen Möglichkeiten, rechtlichen Vorgaben und der Forderung nach zuverlässigen Ergebnissen wider. Die Verzögerung wird somit nicht als Nachteil, sondern als ein notwendiger Bestandteil gesehen, um die Nutzerdaten sinnvoll und verantwortungsvoll auszuwerten.

Fazit: Warum die Verzögerung für Nutzer und Google sinnvoll ist

Die verzögerte Auswertung von Nutzerreaktionen bei Google erscheint auf den ersten Blick vielleicht ineffizient, doch sie ist sowohl für dich als Nutzer als auch für Google selbst von großem Vorteil. Diese Verzögerung ermöglicht eine sorgfältige Verarbeitung und Analyse der enormen Datenmengen, die täglich anfallen. So wird sichergestellt, dass die Ergebnisse und personalisierten Angebote möglichst präzise und relevant bleiben.

Für dich als Nutzer bedeutet diese Verzögerung, dass die Suchergebnisse und personalisierte Werbung auf einer stabilen und validen Datenbasis fußen. Die Auswertung in verschiedenen Phasen – von der Rohdatenaufnahme über die Bereinigung bis hin zur Modellanwendung – reduziert Fehler und Verzerrungen, die bei einer unmittelbaren Verarbeitung auftreten könnten. Dadurch erhältst du qualitativ hochwertige Suchergebnisse und Anzeigen, die auf echten Trends und Verhaltensmustern basieren, anstatt auf Momentaufnahmen von einmaligen Klicks oder Interaktionen.

Für Google ist die verzögerte Auswertung essenziell, um komplexe Algorithmen und maschinelle Lernverfahren optimal einzusetzen. Echtzeitdaten sind oft verrauscht und können Fehlanpassungen im Algorithmus hervorrufen. Eine sorgfältige zeitlich gestaffelte Analyse hilft zudem, betrügerische Aktivitäten oder automatisierte Bots besser zu erkennen und auszuschließen, was die Integrität der Daten sicherstellt. Zusätzlich ermöglicht die Verzögerung, Datenschutzbestimmungen einzuhalten und Nutzerdaten nur nach entsprechender Prüfung weiterzuverarbeiten.

Zusammengefasst dient die Verzögerung bei der Auswertung also der Datenqualität, der Sicherheit und der Einhaltung gesetzlicher Vorgaben. Sie ist kein Zeichen von Ineffizienz, sondern vielmehr ein essenzieller Bestandteil eines robusten und vertrauenswürdigen Such- sowie Werbe-Ökosystems.